Escrito por Miguel Ángel Culiáñez

Índice

¿Qué es el crawl budget?

El crawl budget o presupuesto de rastreo podría definirse como el volumen de dedicación que Google asigna a rastrear e indexar el contenido existente en un determinado sitio web.

¿Cómo se mide?

Se tiende a asociar este volumen de dedicación con el tiempo destinado por parte de los crawlers o “arañas” de Google (también conocidos como bots) para efectuar dicho rastreo, si bien debe tenerse presente que ese tiempo como unidad de medida tendrá siempre una traslación en términos de consumo de recursos energéticos. Por tanto, esa dedicación podría medirse también en términos monetarios. De ahí que el concepto cuente con el término budget o presupuesto dentro de su denominación.

Hay quien prefiere asociar el crawl budget con el alcance del rastreo efectuado por parte de las arañas como unidad de medida. Es decir, con el número total de páginas que Google logra rastrear en cada visita al site. Esto se debe principalmente a que se trata de un dato abierto que podemos consultar a través de nuestra cuenta de Google Search Console. El tiempo, la energía y la inversión monetaria efectuada por Google en el rastreo de nuestro sitio web, por el contrario, es algo que solo conocen los de Mountain View. No obstante, aún en el hipotético caso de disponer de esa información, el volumen total de contenido indexado resulta más bien la consecuencia derivada de disfrutar de un mayor o menor crawl budget. En otras palabras, a mayor dedicación (en tiempo, energía y dinero) por parte de Google para rastrear un site, mayor volumen de páginas rastreadas y, con suerte, indexadas. O, al menos, mayores posibilidades de que así sea.

En resumen, desempeñar cualquier actividad requiere tiempo y energía, lo cual se traduce en inversión económica. Resulta necesario tener presente tal obviedad para entender la raíz del concepto crawl budget, ya que rastrear un sitio web no es una actividad gratuita para Google. No digamos ya cuando de rastrear millones de sitios web al día se trata. De ahí que el gigante tecnológico trate de optimizar los recursos dedicados al proceso de rastreo y su dedicación asignada en dicha labor para cada sitio web deba verse limitada.

¿Por qué es importante el crawl budget o presupuesto de rastreo?

Disfrutar de un elevado crawl budget implica lograr que los bots de los diferentes buscadores rastreen nuestro sitio web con más frecuencia, dedicando más tiempo y analizando una mayor cantidad de páginas. Ello se traduce a su vez en más posibilidades de que una mayor cantidad de nuestras páginas y su contenido correspondiente sean tenidas en consideración de cara a dar respuesta a las diferentes intenciones de búsqueda de los usuarios y ocupen posiciones más altas entre los resultados de búsqueda.

En contraposición, sufrir un bajo presupuesto de rastreo empeora nuestras opciones de éxito en términos de posicionamiento web, al no contar con tiempo de atención suficiente por parte de los buscadores para que encuentren e indexen nuestro contenido más reciente, o lo terminen haciendo más tarde que en el caso de nuestros rivales. Posiblemente, también se tardará más tiempo en identificar y tener en consideración aquellas mejoras o actualizaciones llevadas a cabo sobre páginas ya indexadas anteriormente.

Seis recomendaciones para mejorar el crawl budget de tu sitio web

A estas alturas la gran pregunta que cabe plantearnos es la siguiente: ¿de qué depende, por tanto, que nuestro sitio web goce de una mayor o menor dedicación por parte de Google y el resto de los buscadores?

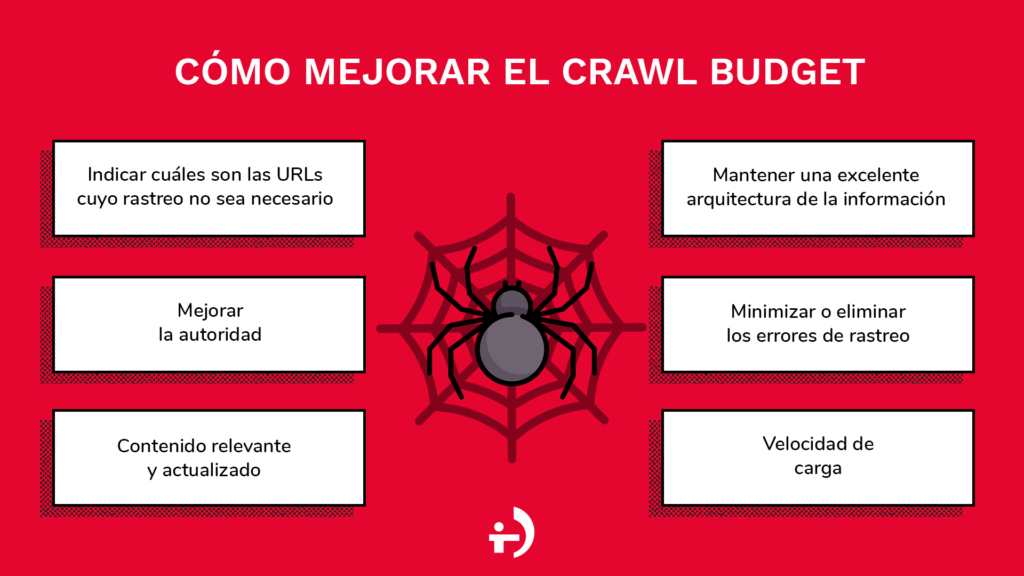

En este sentido, resulta lógico pensar que, si deseamos que Google y el resto de los buscadores dediquen un mayor esfuerzo en el rastreo de nuestro sitio web frente al de los rivales, deberemos incentivarle para ello y, por supuesto, deberemos ponerle las cosas fáciles. Por ello, a continuación, te hablamos sobre ciertos aspectos clave a considerar de cara a mejorar el crawl budget de tu proyecto web:

- Indicar cuáles son las URLs cuyo rastreo no sea necesario: una de las acciones básicas que deberíamos llevar a cabo es la de ser considerados con los robots y respetar su valioso tiempo de rastreo. Si sabemos que nuestro sitio web cuenta con páginas que no aportan nada en términos de posicionamiento web, será un auténtico detalle actualizar el fichero robots.txt para indicar a Google qué URLs no es necesario rastrear.

- Mejorar la autoridad: la autoridad de página es uno de los criterios que emplean las arañas de Google de cara a determinar la atención que debe dedicar en su rastreo, por ello, es altamente recomendable en este sentido trabajar en profundidad sobre aspectos de linkbuilding y linkbaiting. Una página que atraiga la atención de otros muchos portales de calidad y relacionados con nuestra temática será merecedora de una especial atención también por parte de Google. En este otro artículo encontrarás consejos muy interesantes sobre cómo lograr links de calidad.

- Contenido relevante y actualizado: las páginas con contenido de calidad y actualizado son páginas relevantes y Google lo sabe. Cuando una determinada página lleva tiempo sin actualizarse, la interpretación de las arañas de Google suele ser la de considerarla una página menos atrayente que otras del site y, por tanto, la tendencia es la de terminar por mostrar menos interés y reducir o eliminar cualquier tiempo de rastreo sobre ella. En otras palabras, ¿por qué iba Google a destinar esfuerzos de forma recurrente para rastrear el contenido de una página a la cual nosotros mismos como gestores del site no prestamos la suficiente atención? Resultará así necesario que aquellas páginas que sean clave se actualicen periódicamente. En relación con todo lo anterior, implementar una filosofía de contenido evergreen para mantener actualizada únicamente la información más relevante, pero de forma permanente, también ayudará a optimizar tu propio tiempo y esfuerzo (y no solo el de Google), llegando a obtener posiblemente mejores resultados que si basases tu estrategia de contenido en cantidad frente a calidad.

- Mantener una excelente arquitectura de información: como es lógico, cuando de encontrar información, clasificarla y evaluarla se trata, las arañas de Google aplican principios esenciales. Uno de ellos consiste en que, a mejor organización de la información, más fácil y rápida resultará esta tarea. Por obvio que resulte, gozar de un sitio web con una brillante arquitectura de información repercutirá directamente en la mejora del crawl budget. En relación con ello, no está de más recordar también la importancia de mantener siempre actualizado el archivo sitemap de nuestro sitio web. Si tu proyecto web consiste en la venta online y deseas profundizar sobre arquitectura de información, posiblemente te resultará interesante leer también este otro artículo sobre arquitectura de información en e-commerce.

- Minimizar o eliminar errores de rastreo: resulta altamente recomendable trabajar para mantener nuestro sitio web libre de errores (o al menos mantenerlos en niveles muy bajos) que puedan perjudicar la labor de los buscadores. Nos referimos, por ejemplo, a enlaces internos rotos, existencia de errores de tipo 404 generados por diferentes causas y que no cuenten aún con el oportuno redireccionamiento, páginas con contenido duplicado entre sí, presencia de URLs no descriptivas, etc. En definitiva, se trata de revisar periódicamente nuestro sitio web y subsanar todos aquellos errores on-page o puntos de mejora que encontremos para facilitar al máximo el acceso y comprensión de nuestro contenido.

- Velocidad de carga: por último, pero no menos importante, resulta ser la velocidad de carga de nuestro site. De nuevo estamos ante un elemento clave no sólo de cara a contentar a los buscadores, sino también al propio usuario. A ninguno de los dos les gusta tener que esperar para poder acceder al contenido que pretendemos ofrecerles. La rapidez de carga permitirá que el mayor tiempo posible pueda dedicarse al rastreo por parte de los bots y que estos no tengan que soportar esperas más largas de lo estrictamente necesario. Si los buscadores se topan con una página excesivamente lenta, lo más probable es que el contenido de dicha página quede sin ser rastreado y tenido en cuenta. Cuando todas las páginas del site o una gran cantidad de ellas cuenten con dicha dificultad, estaremos ante un verdadero problema de rastreo.Los aspectos que pueden hacer que una página o un sitio web en su totalidad sean excesivamente lentos pueden ser muchos. De hecho, sería recomendable entender los elementos clave de WPO (Web Performance Optimization) para valorar en su integridad la complejidad de esta cuestión, pero podríamos mencionar a un mejorable servicio de hosting o a un peso excesivo de imágenes como algunas causas habituales que suelen encontrarse detrás de problemas relacionados con la velocidad de carga.

Un interesante artículo que cobra mucho sentido. Teniendo en cuenta que GooGle no es un buscador. Es una empresa que contiene un buscador. El cual consume una serie de recursos, incluido electricidad, humanos y almacenamiento. Apuesto que artículos tan interesantes como este y de gran aportación de contenido no duda en «crawlbudgetearlo» nada más ser indexado. Va para Twitter.