Escrito por Fernando Maciá

Índice

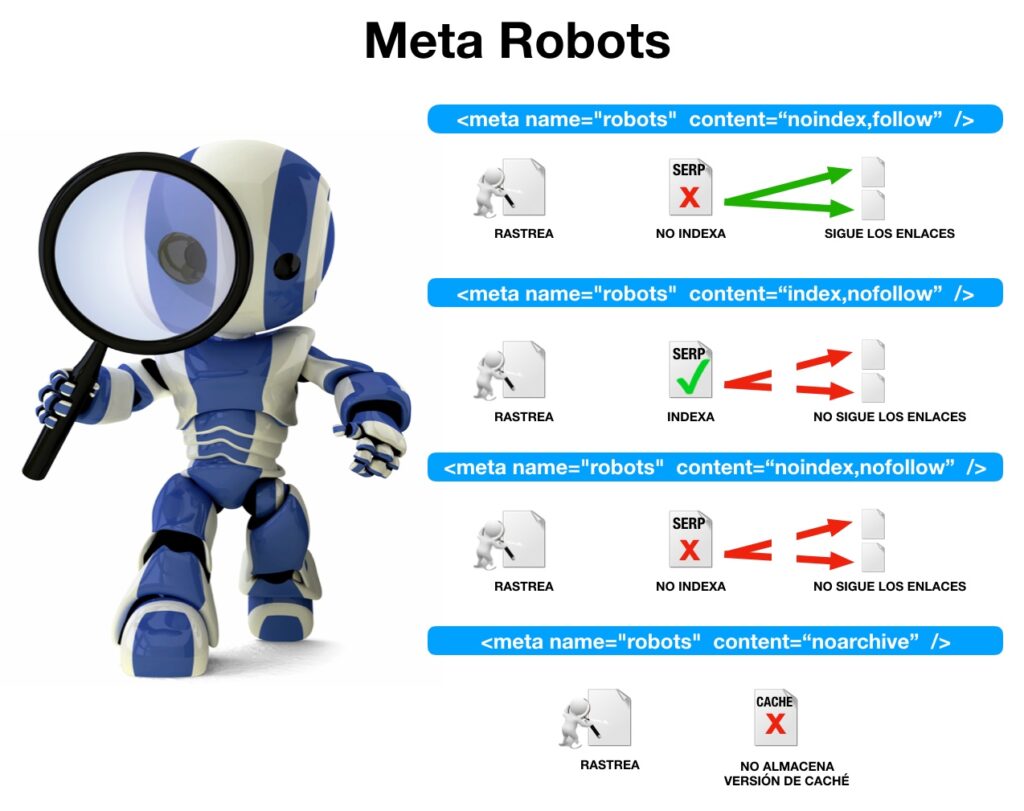

La meta robots es una metaetiqueta HTML que sirve para dar instrucciones a las arañas de los buscadores respecto al rastreo e indexación de la página web donde está implementada. Con la meta robots damos directrices para que indexen o no una página, o para que sigan o no los enlaces hacia otras páginas, impidiendo su rastreo.

Para qué sirve

La meta robots permite controlar la forma en que se debe indexar una página y la forma de mostrarla a los usuarios en la página de resultados de búsqueda.

Su uso habitual se aplica para indicar directivas negativas, pues el rastreador las entiende como positivas en caso de no indicar lo contrario. Por defecto ya son interpretadas en positivo.

Es obvio, pero no debemos especificar ninguna metaetiqueta robots en el caso de que queramos que los buscadores indexen la página. Por eso hay que estar muy atentos a no incluirlas o quitarlas en aquellos portales que las usan en pruebas y que van a lanzar la versión definitiva que quieren indexar, para que el rastreo se lleve a cabo sin problemas.

Dónde y cómo se implementa la metaetiqueta robots

La ubicación de la meta robots debe hacerse dentro de la sección <head> de la página en cuestión.

Además, necesita contener dos atributos, name y content para poder funcionar correctamente.

Ejemplo de implementación de la meta robots:

<!DOCTYPE html>

<html>

<head>

...

<title>...</title>

<meta name="robots" content="noindex" />

...

</head>

<body>

...

</body>

</html>

Atributo content: Directivas

Los valores que pueden acompañar a la metaetiqueta robots para poder dar diferentes indicaciones cara a la indexación o forma de publicación de la página, pueden ser varios y se indican dentro del atributo «content».

Podemos dar tantas directrices como estimemos oportunas siempre que, al incluirlas, estén separadas por comas.

Principales directivas de la meta robots:

- index / noindex: con la que indicaremos a los crawlers si deseamos indexar o no la página web en sus motores de búsqueda para que aparezca o no en los resultados de búsqueda de los mismos. Si no queremos indexarla, con noindex le diremos que no muestre esta página en sus resultados.

- follow / nofollow: indica a la araña si debe rastrear y seguir, o no, los enlaces que contiene la página en cuestión.

- archive / noarchive, señala si queremos que el robot pueda almacenar o no el contenido de la página web en la memoria caché interna del buscador.

- snippet / nosnippet: para que sólo muestre el título y no la descripción en los resultados de búsqueda.

- odp / noodp: cuando no queremos que los buscadores extraigan metadatos del Open Project Directory, en los títulos o descripciones de la página que muestran en los resultados. (En general, se entiende que esta directiva es obsoleta debido a que el Directorio Open Directory Project ha caído en desuso).

- ydir / noydir, similar a la anterior, pero para el directorio de Yahoo!. (En general, se entiende que esta directiva es obsoleta debido a que el Directorio Yahoo! ha caído en desuso).

- translate / notranslate: para ofrecer o no la traducción de la página en los resultados de búsqueda.

- noimageindex: para no indexar las imágenes de la página.

- unavailable_after [RFC-850 date/time]: cuando no queremos que se muestre la página en los resultados de búsqueda a partir de la fecha y hora señaladas.

Ejemplos de uso de meta robots e interpretación de las directivas

Citamos algunos ejemplos de meta robots y el significado de lo que queremos indicarle a los rastreadores de los buscadores con ello:

<meta name="robots" content="index,follow" />

Es la etiqueta por defecto de cualquier página web y no es necesario incluirla. Indica al rastreador que rastree, indexe y siga los enlaces contenidos en la página web. Es innecesaria porque éste es el comportamiento por defecto de cualquier robot.

<meta name="robots" content="index,nofollow" />

Queremos que se indexe la página pero que no se sigan los enlaces que contiene la misma. Se suele incluir cuando no deseamos que las páginas enlazadas se indexen bien por estar bloqueadas por una metaetiqueta robots con la directiva «noindex» o bien por estar bloqueadas con una instrucción «disallow» desde el archivo robots.txt.

<meta name="robots" content="noindex,follow" />

En este caso, queremos que no se indexe la página que incluye la meta pero sí queremos que el robot descubra y rastree las páginas enlazadas desde la misma. Se suele incluir en resultados paginados cuando el número de páginas de la serie es muy extenso.

<meta name="robots" content="nofollow,noodp" />

Cuando deseamos que no se rastreen los enlaces que contiene y no queremos mostrar los metadatos opd en los títulos o descripciones de la página.

Meta robots vs. robots.txt

Tanto la meta robots como las directivas especificadas en el archivo robots.txt de nuestro sitio web nos pueden dar cierto control sobre qué páginas sí deberían indexarse y/o rastrearse y cuáles no. Aunque aparentemente son dos métodos encaminados a lograr el mismo objetivo, optar a nivel SEO por una u otra dependerá del escenario y del fin concreto perseguido.

Para entender las diferencias, es importante distinguir entre rastreo e indexación. En el rastreo, los buscadores acceden al contenido y «leen» la información que contiene una página. Posteriormente, el buscador decide indexar ese contenido en una categoría de búsqueda u otra, o no indexarla en absoluto. Si el buscador no rastrea una página, ahorramos tiempo de rastreo y optimizamos el «crawl-rate» dejando más tiempo al robot para rastrear los contenidos más importantes o actuales. Si, por el contrario, el robot rastrea un contenido pero después no lo indexa, dicho contenido tampoco aparecerá en los resultados pero habremos desperdiciado un tiempo precioso de «crawl-rate» que quizá podríamos haber aprovechado mejor.

Diferencias entre meta robots y robots.txt a nivel de rastreo

Cuando acceden a un nuevo sitio Web, los robots de los buscadores intentan localizar el archivo robots.txt para consultar las directivas especificadas en el mismo. Si una URL se ajusta a alguno de los patrones especificados como no permitidos («disallow») en el archivo robots.txt, el robot simplemente ignorará dicha URL y no se molestará en indexarla. Esto significa que Google no tendrá que emplear tiempo en rastrear un contenido que no queremos que indexe.

Si, por el contrario, el robot de Google encuentra la metaetiqueta robots en una URL, esto significa que ha tenido que acceder y rastrear dicha página. Si en la metaetiqueta robots especificamos que no queremos que indexe la página con la directiva «noindex», Google tampoco mostrará dicho contenido en los resultados.

Aparentemente, hemos logrado el mismo objetivo: evitar que Google muestre determinada URL en sus resultados. Pero el empleo de recursos de Google es distinto. Con el archivo robots.txt no tuvo que acceder a la URL ni rastrear su contenido mientras que con la metaetiqueta robots sí tuvo que emplear un cierto tiempo de rastreo en hacerlo.

Por otro lado, un archivo robots.txt nos da mucha flexibilidad a la hora de definir patrones de URL que no queremos que Google rastree, mientras que una meta robots controla la indexación URL a URL.

Diferencias entre meta robots y robots.txt a nivel de indexación

A pesar de que una directiva «disallow» en el archivo robots.txt evitará que Google acceda a una URL concreta desde un enlace en nuestra propia Web, aún es posible que Google «descubra» y rastree dicha URL si encuentra un enlace apuntando a ella desde un sitio Web distinto, es decir, un enlace externo. Esta es la razón por la que podemos descubrir URLs para las que Google no muestra ninguna descripción al hacer una búsqueda con site:dominio.com.

Por el contrario, una metatag robots con la directiva «noindex» provocará que Google deje de mostrar esa URL en sus resultados totalmente. Google rastreará la URL pero no la añadirá a su índice (obedeciendo esa instrucción «noindex»).

Conclusión

Si prohibimos el rastreo de una URL en el archivo robots.txt, los buscadores no invertirán tiempo en rastrear dicho contenido a menos que lo descubran desde un enlace externo, por lo que podemos optimizar el tiempo que el robot dedica a rastrear nuestros contenidos pero no es un método tan eficaz si no queremos bajo ningún concepto que una página se muestre en los resultados.

Si prohibimos la indexación de una URL desde la metaetiqueta robots Google no indexará dicha URL y no la mostrará nunca en sus resultados, pero habremos desperdiciado un tiempo precioso de rastreo de la araña.

Otras formas de controlar la indexación de una URL concreta

Además de la metatag robots y el archivo robots.txt, hay otras formas de controlar la indexación de páginas en un sitio Web. Como por ejemplo:

Elemento de enlace «canonical»

Cuando especificamos un elemento de enlace «canonical», estamos sugiriendo al buscador con qué URL deseamos que indexe dicho contenido. Esa URL puede ser exactamente la misma con la que accedió al contenido (canonical autoreferenciada) o página canónica, o puede ser distinta, en cuyo caso hablaríamos de URL canonicalizada. En este último caso, podemos indicar a Google que no indexe distintas URLs para un contenido que podría ser detectado como duplicado como, por ejemplo, listados de contenidos ordenados bajo distintos criterios, variantes de un mismo producto en distintos colores o tallas, etc.

Aunque hay que tener en cuenta que para los buscadores, un «canonical» es sólo una sugerencia. Si el buscador encuentra un número significativo de enlaces internos o externos hacia una URL determinada probablemente la indexará incluso aunque esté canonicalizada hacia una URL distinta (es decir, aunque incluya un elemento de enlace «canonical» apuntando a otra página).

Gestión de parámetros en Google Search Console

Otra forma de controlar la indexación o no de determinadas URLs se encuentra en el apartado Gestión de Parámetros de la herramienta Google Search Console. Con ella podemos especificar qué parámetros sí deberían indexarse en una URL (por ejemplo, números identificadores de producto) y cuáles no (por ejemplo, parámetros de seguimiento de campañas o de reordenación de contenidos).

Conclusión

Tanto el elemento de enlace «canonical» como la gestión de parámetros en Google Search Console son métodos para evitar la indexación de URLs que darían lugar a un potencial problema de contenido duplicado. Siempre que es posible, se aconseja ser coherente en la definición de URLs canónicas y la especificación hecha desde la gestión de parámetros de Google Search Console pues aunque esta funcionalidad se enfoca a evitar la indexación de contenido duplicado, es importante entender los distintos efectos que logramos con cada uno de los métodos de gestión de la indexación para aplicar la adecuada en nuestro escenario concreto.